- 입력 2016.08.10 16:42

[뉴스웍스=김벼리기자]

#1. 지난 5월 7일 미국플로리다의 한 고속도로 교차로. 자율주행 기능으로 이동하던 테슬라 모델S가 마침 좌회전을 하던 대형 트레일러와 충돌했다. 모델S의 앞유리가 트레일러 바닥 부분과 부딪혀 산산조각 났고 테슬라 운전자는 결국 사망했다.

이후 테슬라는 “사고 당시 운전자와 오토파일럿 시스템이 다가오는 트레일러를 인식하지 못한 것으로 보인다”고 밝혔다.

#2. 지난 2010년 5월 6일 오후 2시. 42분에서 47분 사이에 미국 증시의 1/10에 해당하는 1조 달러가 증발했다. 불과 5분 만이었다. 당시 초단타매매(HFT; High-Frequency Trading) 인공지능(AI)들이 부족한 매수 주문을 확인하자마자 서로 손실을 최소화하기 위해 경쟁적으로 팔아치우는 행위가 초래한 결과였다.

둘 다 인공지능(AI)의 위험성을 적나라하게 보여주는 사례들이다. 그런데 여기서 드러나는 문제는 두 사례에서 그 성질이 각각 다르다. 전자는 분명히 AI ‘시스템상의 오류’ 때문에 발생한 사고지만, 후자에서 문제의 원인은 오류에 있지 않다.

지난 1956년 AI의 개념이 처음 등장한 뒤 이를 향해 쏟아져온 우려는 크게 두 종류였다. 하나는 불완전한 시스템이 문제를 야기할 수 있다는 것이었고, 또 다른 하나는 자율적 판단을 하는 AI가 인간을 위협할 수 있다는 것이었다.

그런데 기술적 문제가 점차 해결, AI가 현실화해감에 따라 후자를 우려하는 목소리가 점점 커지고 있다. 최근 수면 위에 떠오르고 있는 AI의 문제점과 대안, 현황 등을 살펴본다.

◆ 오류를 없애도 남는 문제…AI 자율성이란

일반 기계와 AI의 결정적인 차이는 ‘자율성’에 있다. 그리고 이는 AI만의 독특한 딜레마를 야기한다.

예를 들어 자동차 문을 본체에 이어붙이는 기계가 문제를 일으켰다고 생각해보자. 일부 외적 영향(화재, 정전 등)을 제외하면 그 원인은 전적으로 기계의 오류에 의한 것이다.

앞서 테슬라 모델S 사고도 사실상 이와 같다. 이 둘은 모두 ‘기술적인 불완전성’ 때문에 발생한 문제들인 것이다.

그렇지만 AI의 문제는 단순히 결점, 혹은 오류에 그치지 않는다. 달리 말해 기계와는 달리 AI는 만약 ‘무결점’ 시스템을 개발한다고 할지라도 또 다른 문제가 기다리고 있다.

여기에 바로 AI의 자율성이 있다.

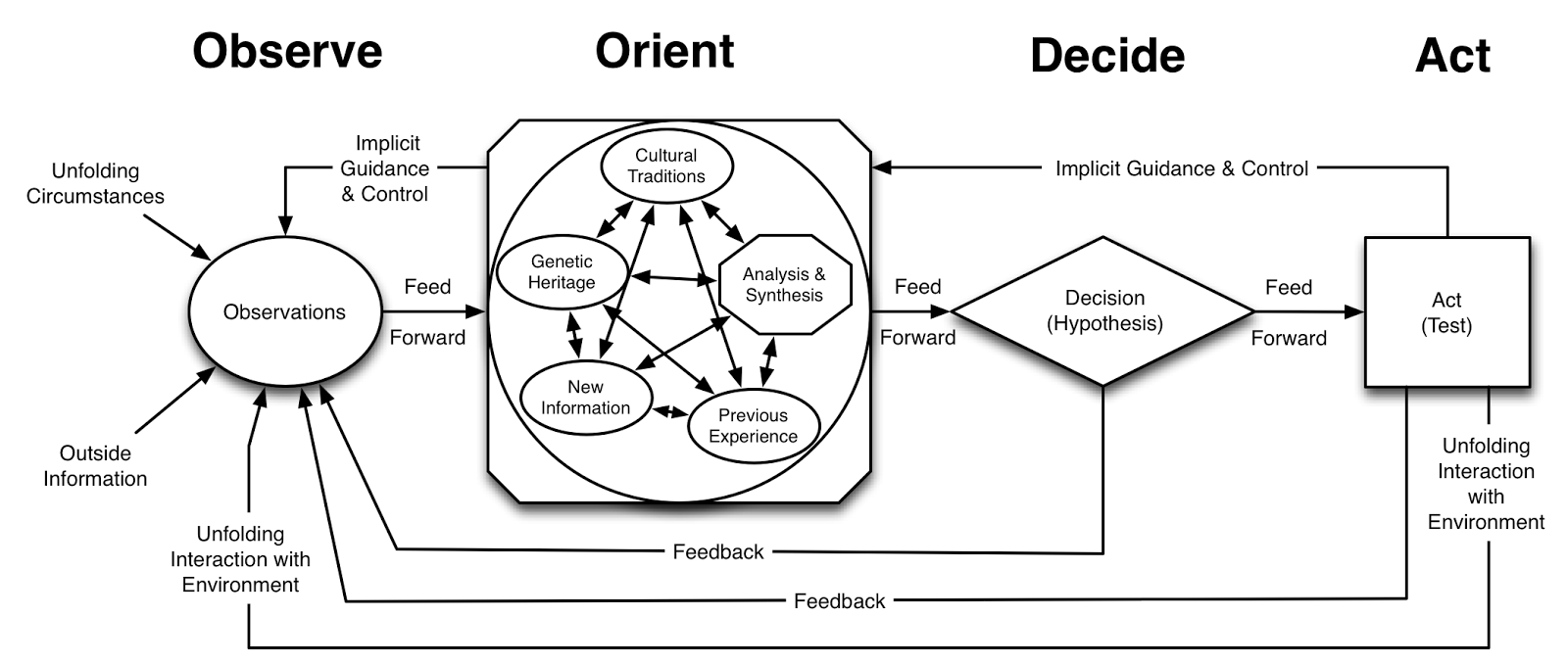

AI의 자율성이란 일반적으로 쓰이는 ‘자율’의 개념과 비슷하다. 학술적으로 말하면 AI의 자율성은 ‘OODA’ 루프다. 풀어 말해 주변 환경을 관찰(Observe)하고 판단(Origin)한 뒤 결심(Decision) 후 행동(Act)까지 각 단계별로 스스로 판단하는 능력이 자율성인 것이다.

이런 자율성은 인간의 개입을 최소화해 인력을 대체하고 업무의 효율성을 극대화하기 위한 방법의 일환으로 등장했다.

◆ '인간 vs AI', 'AI vs AI'…자율성이 야기하는 충돌들

그러나 아이러니하게도 AI의 진정한 문제를 야기하는 것 또한 자율성이다.

제조기계 등의 시스템은 오류가 나지 않는 한 특정 명령(input)에는 특정 결과(output)만을 내놓는다. 예컨대 쌀을 넣으면 밥을 만드는 식이다. 반면 AI 시스템에는 고정된 메커니즘이 없다. 똑같은 쌀을 넣어도 AI의 판단에 따라 밥, 떡, 국수 등 다양한 결과가 나올 수 있다.

따라서 AI의 자율성이 극대화한다는 말은 달리 말해 그만큼 AI가 인간의 통제권에서 벗어나게 된다는 것과 같다. 그 결과 인간이 원했던 것과는 정반대의 행동을 AI가 할 가능성이 생기며, 더 나아가 인간과 AI의 충돌까지 이어질 수 있는 것이다.

예를 들어 AI 알람이 있다고 해보자. 대학생인 K는 공강 시간을 활용해 집에서 낮잠을 자고 있는데 수업 20분 전에 맞춰 알람이 스스로 울리기 시작한다. 머리가 아프고 어지러운 K는 계속 잠을 청하고 싶지만 ‘K를 깨우는 것’을 목표로 삼은 알람은 계속해서 울린다.

이런 충돌은 가구·가전 기기, 의료행위, 자율주행차, 킬러로봇 등 다양한 분야에서 끊임없이 발생할 것이다.

뿐만 아니라 AI끼리도 충돌할 여지가 있다. 특정 목표만을 달성하기 위해 단편적으로 행동하는 AI들 사이의 어긋남이 전체 시스템의 오류를 야기할 수 있는 것이다.

실제로 지난 2003년 이라크전에서 미국의 패트리어트 미사일이 아군 전투기를 잘못 격추하는 사건이 수차례 벌어졌는데, 추후 당시 실수가 AI간의 충돌 때문이었다는 사실이 밝혀지기도 했다.

◆ 자율성 제한, 어디까지?…‘우호적 인공지능’, ‘로봇윤리’ 등 논의 확산

최근 이 같은 문제들이 연이어 발생하자 AI의 자율성을 두고 갑론을박이 벌어지고 있다.

그중에는 자율성을 아예 제거해야 한다고 주장하는 극단적인 입장도 있다. 그러나 그렇게 되면 AI의 존재이유가 의미를 잃게 된다.

따라서 현재 관련 연구·업계에서는 ‘AI의 자율성을 어느 수준까지 제한해야 하는가’를 두고 활발한 논쟁을 벌이고 있는 상황이다.

최근 관련 연구를 살펴보면 합의를 위한 몇 가지 기준들을 갖춰져나가고 있는 모양새다.

우선 ‘용도 적합성’이 있다. 어떤 용도에 쓰이느냐에 따라 맞춰 AI의 자율성 수준을 정해야 한다는 주장이다. 또한 ‘결과의 가역성’은 AI의 특정 행위가 결과를 돌이킬 수 없을 때 자율성을 제한해야 한다는 것이다. 사람을 죽이는 ‘킬러로봇’ 같은 경우가 이에 해당한다. 이밖에도 ‘영향력의 수준’, ‘도덕·윤리적 판단’, ‘개발자의 철학’ 등이 언급된다.

한편 그 와중에 AI를 둘러싼 문제는 다양한 영역으로 파생, 사회 전반적인 이슈와 맞물려가고 있다.

일례로 인공지능 개발자들은 인류에 위협을 가하지 않는 인공지능인 ‘우호적 인공지능(FAI; Friendly Artificial Intelligence), 인공지능의 폭주를 막기 위한 강력한 안전 장치인 ’킬 스위치(Kill Switch)‘ 등을 고안, 개발하고 있다.

또한 윤리적 차원에서 AI를 접근하는 '로봇윤리(Roboethics)'도 등장했다. 지난 2000년대 초반 처음 나온 로봇윤리란 AU와 밀접하게 맞물린 윤리·사회적 문제의 해결방안을 모색하기 위한 학문 연구를 수행하고 있다.

법적인 차원에서도 AI 관련 논의가 이어지고 있다. 항공, 자동차 분야에서는 이미 여러 선진국에서 AI 관련 법규 및 제도를 도입, 정비하고 있는 상황이다.

심지어는 AI의 법적인 지위도 논의선상에 올라가 있다. 실제로 지난 5월 EU가 발표한 로봇 관련 보고서에는 AI로봇에게 전자인간(Electronic Person) 자격을 부여해 권리와 의무를 부과, 로봇 고용자에게 로봇 관련 세금을 부과하자는 내용이 담겨있다.